AI Act uchwalony! Nowy rozdział w regulacji sztucznej inteligencji.

W ostatnich latach świadomość rosnącego wpływu sztucznej inteligencji (AI) na społeczeństwo i gospodarkę staje się coraz bardziej powszechna. W odpowiedzi na pojawiające się wyzwania związane ze stosowaniem AI, Unia Europejska od lat podejmuje wysiłki w celu ustanowienia kompleksowych ram prawnych stosowania sztucznej inteligencji. Zwieńczeniem tego procesu jest przyjęcie aktu w sprawie sztucznej inteligencji (AI Act) przez Parlament Europejski w marcu 2024 roku.

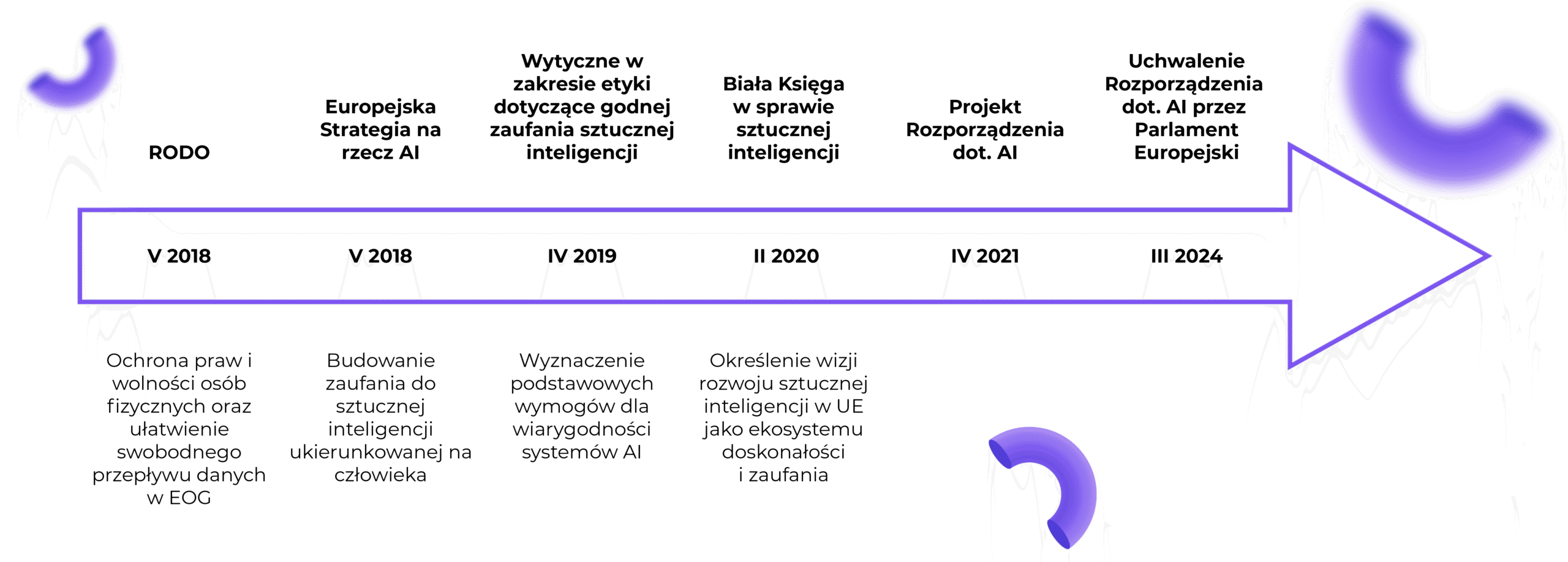

Jak wyglądała droga do uchwalenia AI Act?

Działania prowadzące do prawnego uregulowania sztucznej inteligencji przez UE trwają już od 2018 r., kiedy to przyjęto Europejską Strategię na rzecz AI. Dokumentami, które legły u podstaw zasad przyjętych w Rozporządzeniu dot. AI, były również Wytyczne w zakresie etyki dotyczące godnej zaufania sztucznej inteligencji (2019) oraz Biała Księga w sprawie sztucznej inteligencji (2020).Prace nad projektem AI Act rozpoczęto w 2021 roku i były one niezwykle złożone ze względu na konieczność uwzględnienia różnorodnych perspektyw. W toku prac prowadzone były tzw. trilogi, czyli trójstronne negocjacje z udziałem Parlamentu Europejskiego, Komisji Europejskiej oraz przedstawicieli państw członkowskich UE wchodzących w skład Rady Unii Europejskiej. Trilogi miały na celu uwzględnienie interesów reprezentowanych przez każdą ze stron, lecz jednocześnie przyczyniły się do znacznego wydłużenia procesu legislacyjnego. Ostatecznie 13 marca 2024 roku AI Act został przyjęty przez Parlament Europejski, a jego finalna wersja dostępna jest tutaj.

Dlaczego AI Act jest kluczowym elementem transformacji cyfrowej?

AI Act stanowi pierwszą tak kompleksową regulację dotyczącą sztucznej inteligencji na świecie. Jego głównym celem jest stworzenie ram prawnych regulujących rozwój, stosowanie i nadzór nad sztuczną inteligencją w UE. Jak wspominaliśmy m.in. w tym artykule, dokument ten ma zapewnić równowagę między promowaniem innowacji a ochroną praw człowieka oraz bezpieczeństwem publicznym. AI Act dąży do zapewnienia przejrzystości, odpowiedzialności i bezpieczeństwa w stosowaniu sztucznej inteligencji, aby zbudować zaufanie społeczne do tych technologii.

Kogo dotyczy AI Act?

AI Act dotyczy przede wszystkim dostawców sztucznej inteligencji wprowadzających do obrotu lub oddających do użytku systemy AI w Unii. Ponadto AI Act obejmie także podmioty stosujące systemy AI, jeżeli mają siedzibę lub znajdują się w Unii (również wtedy, gdy dostawca lub podmiot stosujący system AI znajduje się w państwie trzecim, ale wyniki działania systemu AI są wykorzystywane w Unii).

Definicja systemu sztucznej inteligencji na gruncie AI Act

Definicja systemu sztucznej inteligencji ulegała licznym zmianom w toku prac nad AI Act. Ostatecznie, za system sztucznej inteligencji uznano:

“system maszynowy, zaprojektowany do działania z różnym poziomem autonomii, który może po wdrożeniu wykazywać zdolność adaptacji i który – do wyraźnych lub dorozumianych celów – wnioskuje, jak generować na podstawie danych wejściowych wyniki, takie jak predykcje, treści, zalecenia lub decyzje, które mogą wpływać na środowisko fizyczne lub wirtualne„

Warto zwrócić uwagę, że część terminów użytych w finalnej wersji definicji nie jest na tyle precyzyjna, aby w każdym wypadku stwierdzić z całą pewnością, czy dany system spełnia kryteria definicji sztucznej inteligencji. Niemniej, AI Act został zaprojektowany z myślą o przyszłości, co sugeruje, że jego ramy regulacyjne powinny pozostać odpowiednie nawet w obliczu dynamicznych zmian środowiska technologicznego, co może być uzasadnieniem tak szerokiej definicji.

Klasyfikacja systemów sztucznej inteligencji na gruncie AI Act a obowiązki dostawców

Na gruncie AI Act uregulowano wdrażanie i korzystanie z systemów sztucznej inteligencji, wśród których szczególnie wyróżniono systemy sztucznej inteligencji wysokiego ryzyka. Za takie systemy zostały uznane np. systemy sztucznej inteligencji przeznaczone do wykorzystania w celu rekrutacji czy systemy sztucznej inteligencji przeznaczone do wykorzystania w celu oceny zdolności kredytowej osób fizycznych.

Katalog obowiązków przewidzianych dla dostawców lub dystrybutorów systemów AI zależy od tego, do której grupy systemów będzie kwalifikowany dostarczany przez nich system.

Wśród obowiązków związanych z systemami AI, które nie spełniają kryteriów uznania za system wysokiego ryzyka, wyróżnić można między innymi:

- respektowanie listy zakazanych praktyk,

- rejestrację dostawcy i systemu w bazie danych UE,

- projektowanie systemów AI w taki sposób, aby użytkownicy byli informowani, że wchodzą w interakcję z systemem AI w jasny i wyraźny sposób najpóźniej w momencie pierwszej interakcji z systemem.

W katalogu obowiązków związanych z systemami wysokiego ryzyka znalazły się między innymi:

- wymóg wdrożenia systemu zarządzania ryzykiem,

- stosowanie mechanizmów audytu i nadzoru,

- specjalne wymogi dotyczące dokumentowania zdarzeń, przejrzystości funkcjonowania systemów AI o wysokim ryzyku oraz monitorowania ich pracy przez człowieka, a także

- konieczność przeprowadzania oceny wpływu wprowadzanego do użytku systemu AI na fundamentalne prawa człowieka, w toku tzw. FRIA (fundamental rights impact assessment).

Zakazane praktyki

Co niezwykle istotne, w treści AI Act przewidziano szereg zakazanych praktyk, których stosowanie może skutkować otrzymaniem dotkliwej kary pieniężnej.

Są to między innymi:

- stosowanie manipulacyjnych lub zwodniczych technik, których celem lub skutkiem jest zniekształcenie zachowania danej osoby poprzez osłabienie jej zdolności do podjęcia świadomej decyzji,

- wprowadzanie do obrotu lub używanie systemu AI, który wykorzystuje jakąkolwiek słabość danej osoby ze względu na jej wiek, niepełnosprawność, sytuację społeczną czy ekonomiczną,

- wprowadzanie do obrotu lub wykorzystywanie systemów sztucznej inteligencji do wnioskowania o emocjach danej osoby w miejscach pracy i instytucji edukacyjnych (w tym zakresie wyjątkiem jest wykorzystywanie danego systemu ze względów medycznych lub bezpieczeństwa), a także

- stosowanie zdalnych systemów identyfikacji biometrycznej „w czasie rzeczywistym” w publicznie dostępnych przestrzeniach do celów egzekwowania prawa, chyba że takie stosowanie jest bezwzględnie konieczne ze względu np. na bezpośrednie zagrożenie zdrowia, życia czy atak terrorystyczny.

Sankcje przewidziane w AI Act

AI Act przewiduje bardzo wysokie sankcje w przypadku naruszenia przepisów, co ma stanowić skuteczny środek zapobiegania nadużyciom i ochrony interesów społecznych.

Stosowanie zakazanych praktyk może skutkować otrzymaniem kary w wysokości do 35 mln EUR lub 7% całkowitego rocznego światowego obrotu przedsiębiorstwa (w zależności od tego, która kwota okazałaby się wyższa).

Niewypełnienie obowiązków takich jak posiadanie systemu zarządzania ryzykiem czy prowadzenie dokumentacji w przypadku systemu wysokiego ryzyka, a także m.in. zaniechanie przekazywania użytkownikom informacji o wejściu w interakcję z systemem AI, może skutkować karą pieniężnej w wysokości do 15 mln EUR lub 3% całkowitego rocznego światowego obrotu przedsiębiorstwa (w zależności od tego, która kwota okazałaby się wyższa).

Ponadto, przewidziano również karę w wysokości 7,5 mln EUR lub 1% całkowitego rocznego światowego obrotu za podanie nieprawdziwych lub niepełnych informacji właściwym organom.

Podsumowanie

Choć większość postanowień AI Act zacznie obowiązywać dopiero po upływie 24 miesięcy od wejścia w życie, AI Act (z pewnymi wyjątkami np. w zakresie przepisów dotyczących zakazanych praktyk, które wejdą w życiu już po upływie 6 miesięcy od tego momentu), to niewątpliwie warto już dziś podjąć działania służące dostosowaniu prowadzonej działalności do założeń tego aktu.

Jeżeli masz pytania dotyczące wpływu AI Act na Twój biznes, skontaktuj się z nami – chętnie odpowiemy na Twoje pytania!

Autorki: Olga Dąbrowska i Aleksandra Woźniak